- Home

- Analyses d’applications gratuites

- Invoke - Local LLM Client

Analyse de l'application Invoke - Local LLM Client pour le 26 décembre

Invoke - Local LLM Client

- kazuhiko sugimoto

- App Store Apple

- Gratuit

- Outils de développement

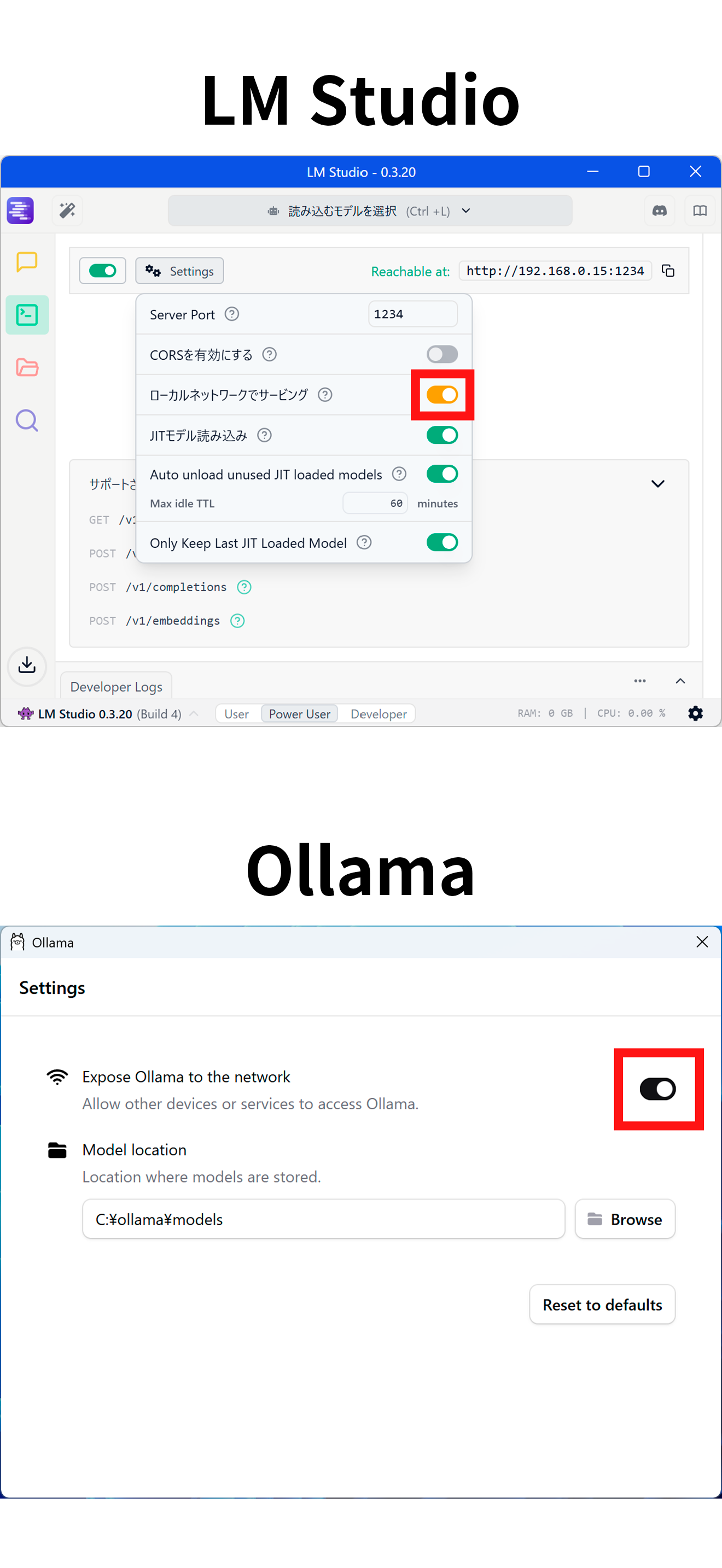

Note: This app is intended for users who are able to set up a local LLM server (Ollama or LM Studio) within their own LAN environment. Some technical setup is required.

Chat with your local LLM! Seamlessly connect to Ollama or LM Studio for a fully offline, privacy-focused AI chat experience!

This iOS app connects to a locally hosted Large Language Model (LLM) server and enables seamless, natural conversations.

Compatible with Ollama and LM Studio via HTTP, it provides real-time message streaming and intuitive chat history management.

The app operates entirely within a local network—no internet connection required—making it ideal for those who prioritize privacy and security.

Key Features:

- Easy connection to local LLM servers (Ollama / LM Studio)

- Natural chat UI with bubble-style layout

- Auto-saving and browsing chat history

- Server and model selection via settings screen

- Supports Dark Mode

Classement dans le store

Le classement des stores est basé sur plusieurs paramètres définis par Google et Apple.

Toutes les catégories dans

États-Unis--

Outils de développement dans

États-Unis#184

Créez un compte pour voir les téléchargements mensuels moyensContactez-nous

Statistiques de classement dans le temps pour Invoke - Local LLM Client

Classement d'utilisation et classement Apple App Store de Similarweb pour Invoke - Local LLM Client

Classement dans la boutique

Classement

Ranking par pays pour Invoke - Local LLM Client

Pays dans lesquels Invoke - Local LLM Client est le mieux classé dans ses principales catégories

Aucune donnée à afficher

Principaux concurrents & apps alternatives

Applications ayant une forte probabilité d'être utilisées par les mêmes utilisateurs, à partir du même store.

LLLM

Mario Cadenas

ai.local

Bruno Wernimont

OMessage - Chat with Local AI

寰宇 骆

AiRC

Ryan Cox

26écembre d, 2025